WTW: Meta kauft bei Scale AI ein, Google zieht sich zurück, China released 1M-Kontext-LLM

TLDR: Die Essenz der Woche

- Meta übernimmt 49 % von Scale AI – und bringt damit Google & Microsoft in Zugzwang.

- Google reduziert seine Ausgaben bei Scale drastisch – von 200 Mio. auf null?

- MiniMax M1: Ein neues Open-Source-LLM aus China beeindruckt mit einem 1-Million-Token-Kontextfenster.

- Midjourney macht jetzt Video – aus Bildern werden kurze animierte Clips.

Diese Woche war ein Paradebeispiel dafür, wie sich strategische Allianzen in der KI-Welt verschieben – und wie China mit Open-Source-Innovationen aufholt.

Meta + Scale AI: Ein Deal mit Nebenwirkungen

Meta hat sich 49 % von Scale AI für 14,1 Mrd. USD gesichert. Das Ziel: Zugriff auf Experten, Trainingsdaten und ein eigenes KI-Team unter Leitung von Scale-CEO Alexandr Wang, der künftig direkt Mark Zuckerberg unterstellt ist.

Scale war bisher auch Dienstleister für Google, Microsoft & Co. – das wird jetzt zum Problem. Google will laut Reuters seine 200 Mio. USD Jahresbudget bei Scale streichen und sondiert bereits Alternativen.

Auch bei Microsoft soll es Überlegungen geben, die Zusammenarbeit zu reduzieren. OpenAI habe das laut Insidern sogar schon vor Monaten getan.

Der Deal könnte Signalwirkung haben: Wenn KI-Startups von Tech-Riesen teilübernommen werden, entsteht automatisch ein Interessenkonflikt für andere Kunden – und das Geschäftsmodell steht auf dem Prüfstand.

MiniMax M1: Chinas Open-Source-Konter gegen GPT-4o

Das chinesische Startup MiniMax hat diese Woche ein LLM unter der Apache-2.0-Lizenz veröffentlicht, das für Aufmerksamkeit sorgt:

Highlights:

- 1 Million Input-Tokens, 80.000 Output-Tokens

- 456 Mrd. Parameter

- Nur 25 % der FLOPs von DeepSeek-R1

- Trainingskosten: gerade einmal 534.700 USD

Das Modell kommt in zwei Varianten (40k und 80k Budget) und basiert auf MiniMax-Text-01. Besonders spannend: die extreme Effizienz beim Training und das enorme Kontextfenster.

Für viele Open-Source-Projekte könnte MiniMax M1 zur neuen Standard-LLM-Infrastruktur werden – besonders für datenintensive Aufgaben und Retrieval-Augmented-Generierung.

Midjourney macht jetzt Video

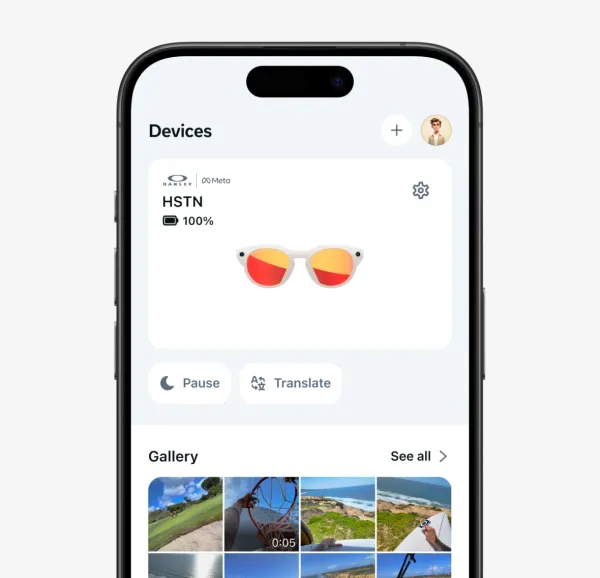

Die beliebte KI-Bildplattform Midjourney hat ein neues Feature:

Aus jedem Bild werden 5-Sekunden-Clips.

Mehr direkt hier:

👉 Midjourney kann jetzt Video – und das ist erst der Anfang

Quellen: